Experten Einstellungen für ChatGPT: Was bedeuten Temperature, Top-P und Co.?

Wussten Sie, dass es versteckte Parameter gibt, mit denen man ChatGPT besser kontrollieren und präzisere Ausgaben erhalten kann? Die wichtigsten dieser Parameter erklären wir in diesem Artikel einfach und verständlich.Kein technisches Vorwissen nötig!

Wie funktionieren Sprachmodelle á la ChatGPT?

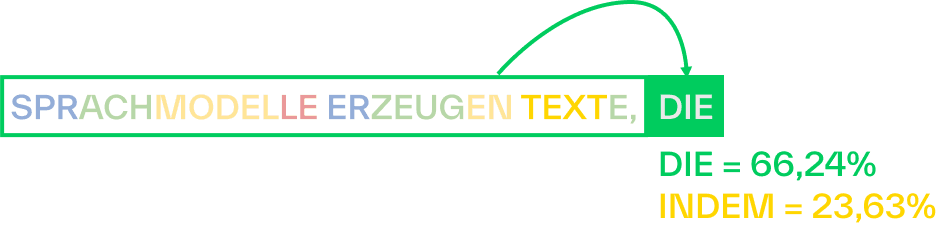

Sprachmodelle erzeugen Texte, indem sie vorhersagen, wie wahrscheinlich das nächste Wort bzw. die nächste Silbe ist. In der Fachsprache sind diese Textbausteine als „Tokens“ bekannt. Das Spachmodell analysiert den bisherigen Text und wählt die Fortsetzung auf Basis von Wahrscheinlichkeiten aus.

Der gesamte Eingabetext wird dabei Silbe für Silbe erweitert. Wenn ein Erweiterungsschritt abgeschlossen ist wird der gesamte bis hierhin erzeugte Text dann wieder in das Sprachmodell eingegeben. Das passiert so lange bis das Sprachmodell selbst ein Stoppsignal sendet und den Text als abgeschlossen markiert. In der folgenden Abbildung erkennt man wie der gesamte Text “SPRACHMODELLE ERZEUGEN TEXTE,” als Grundlage für die Berechnung der Wahrscheinlichkeit des nächsten Textbausteins dient.

Die Fortsetzung mit “DIE” wurde vom Sprachmodell als wahrscheinlicher eingestuft als die Fortsetzung des Textes mit “INDEM”. Diese Einstufung basiert auf den Trainingsdaten mit denen das Modell ursprünglich trainiert wurde und ist maßgeblich für die Ausgaben. Diese Trainingsdaten bestehen aus riesigen Mengen an Texten, in denen das Sprachmodell sich wiederholende Muster erkennt. Auf Basis dieser Daten werden dann die Vorhersagen getroffen und wir erhalten die Fortsetzung mit “DIE VON MENSCHEN GESCHRIEBEN ZU SEIN SCHEINEN”.

Das Sprachmodell entscheidet sich jedoch nicht immer für die wahrscheinlichste Lösung. Das verhindert dass bereits existierende Texte aus den Trainingsdaten 1zu1 wiedergegeben werden und sorgt für vielfältigere Ausgaben. Hier kommt der Einfluss der nachfolgenden Parameter ins Spiel, über die wir die Vielfalt und Kreativität der Ausgaben steuern können.

Parameter von Sprachmodellen

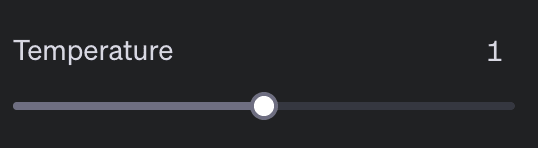

Temperature - Was bedeutet Temperature bei ChatGPT?

Die "Temperature" ist ein Parameter, der kontrolliert wie kreativ oder fokussiert die generierten Texte sind. Sie beeinflusst welcher Textbaustein als nächstes gewählt wird, denn sie verändert der Verteilung der Wahrscheinlichkeiten einzelner Tokens.

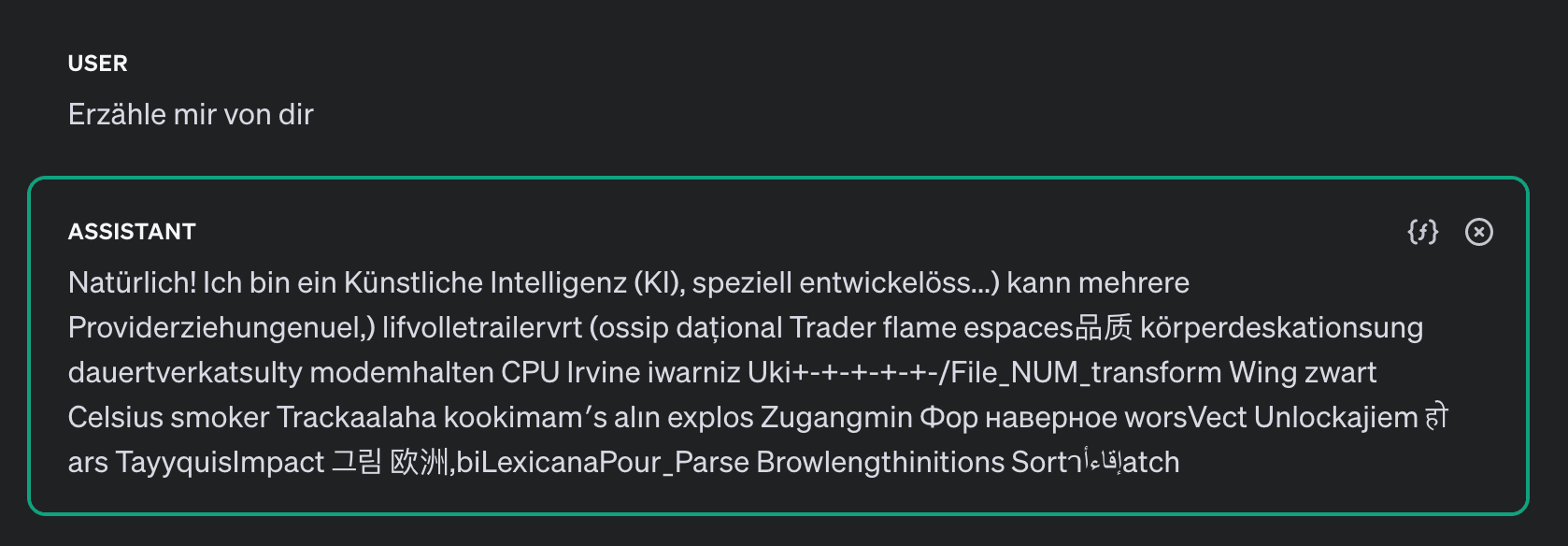

Höhere Werte (zum Beispiel 1,5) sorgt dafür dass unwahrscheinlichere Tokens im Vergleich zu wahrscheinlicheren Tokens häufiger ausgewählt werden und macht die Ausgaben damit zufälliger. Allerdings kann eine zu hohe Temperature auch zu Halluzinationen führen, bei denen das Modell komplett zufällige Token auswählt und die Ausgaben keinen Sinn mehr enthalten.

Niedrigere Werte (zum Beispiel 0,2) machen die Verteilung steiler und die Ausgaben somit fokussierter und deterministischer.

Höhere Temperature-Werte helfen bei kreativen Schreibprojekten oder Brainstorming-Sessions, da so unerwartete und originelle Ideen erzeugt werden können. Niedrigere Werte hingegen sind besser geeignet für Anwendungen, bei denen Präzision und Konsistenz wichtig sind, wie etwa bei professionellen E-Mails oder technischen Dokumentationen.

Halluzinationen bei hohem Temperature Wert von 1,8:

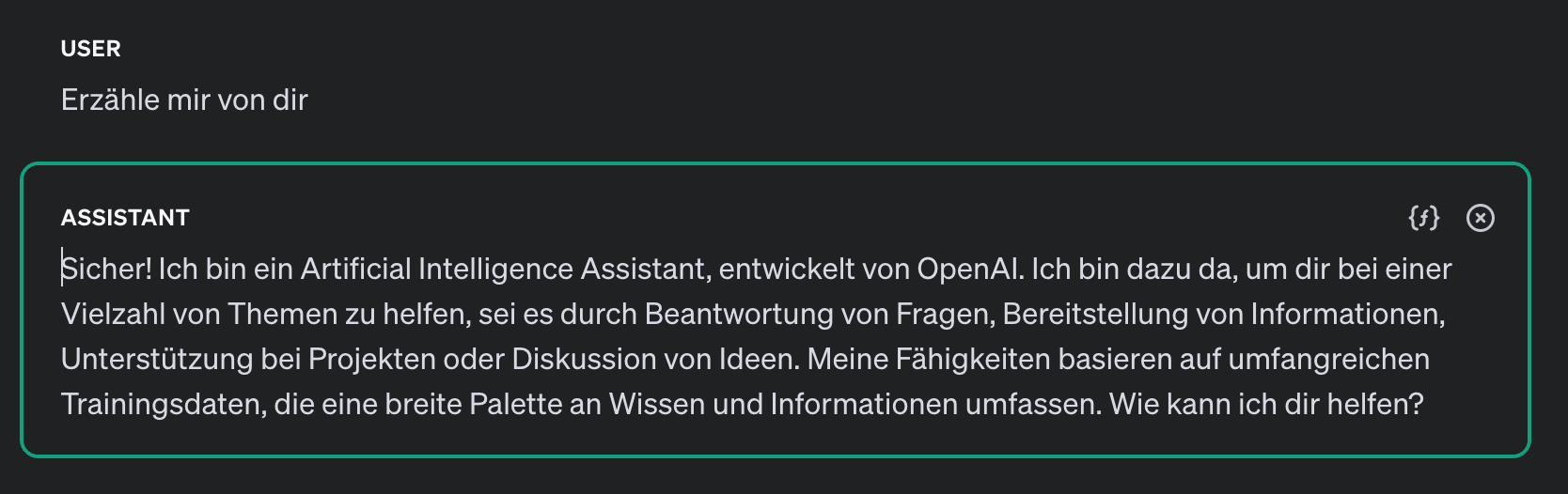

Ausgabe bei Temperature von 1,0:

Ausgabe bei Temperature von 0,2:

Top-P - Was bedeutet Top-P bei ChatGPT?

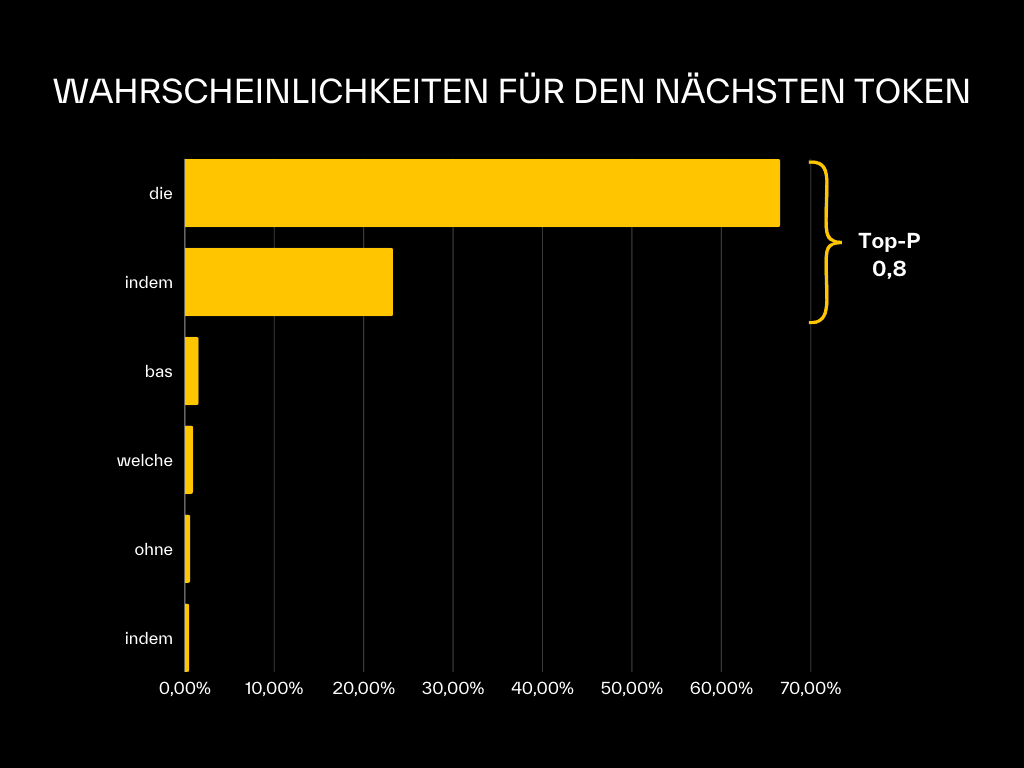

Der Top-P Parameter steuert welche Tokens in die engere Auswahl einbezogen werden. Betrachtet werden nur die Tokens mit der höchsten Wahrscheinlichkeit, bis deren kumulative Wahrscheinlichkeit den Top-P Wert überschreitet.Der maximal Wert für diesen Parameter ist 1, da die Summe aller Wahrscheinlichkeiten immer höchstens 100 % beträgt. Ein Top-P von 0,8 bedeutet, dass nur die Tokens berücksichtigt werden, die zusammen 80 % der höchsten Wahrscheinlichkeit ergeben. Im Beispiel der Abbildung wären das “DIE” und “INDEM”. Andere Tokens werden dann nicht mehr bei der Auswahl berücksichtigt.

Das ist insbesondere dann relevant, wenn Sie mit einer hohen Temperatur arbeiten um kreativere Ergebnisse zu erzielen. So können Sie über den Top-P Parameter die unbrauchbaren Resultate herausfiltern ohne die Kreativität zu reduzieren.

In Kombination mit einer hohen Temperature sollte dieser Parameter daher abgesenkt werden um weiterhin sinnvolle Ausgaben zu erzeugen.

Wahrscheinlichkeitsverteilung für den nächsten Textbaustein mit Top-P 0,8:

Was bedeute Frequency Penalty und Presence Penalty bei ChatGPT?

Durch den Parameter Presence Penalty und Frequency Penalty wird die Generierung von vielfältigeren und kreativeren Texten gefördert, indem das Modell dazu angeregt wird, neue Themen und Wörter einzuführen.

Dabei reguliert der Frequency Penalty die Wahrscheinlichkeit, dass das Modell häufig vorkommende Wörter wiederholt. Ein höherer Wert verringert die Wahrscheinlichkeit von Wiederholungen, indem er die Verwendung häufig bereits im Text vorkommender Wörter oder Phrasen einschränkt. Je häufiger der Textbaustein dabei bereits vorkommt, desto unwahrscheinlicher wird ein weiteres Vorkommen in der Ausgabe. Im Gegensatz dazu bewirkt der Presence Penalty Parameter, dass die Wahrscheinlichkeit, Wörter oder Phrasen, die bereits im generierten Text vorkommen, erneut zu verwenden, reduziert wird. Der Unterschied zur Frequency Penalty ist, dass hier bereits das einmalige Vorkommen des Textbausteins in der Berechnung der Wahrscheinlichkeit bestraft wird. Wohingegen bei Frequency Penalty durch die Häufigkeit bestraft wird. Beide Parameter können Werte zwischen 0 und 2 annehmen.

Verwendung

Ein höherer Wert fördert die Verwendung selten genutzter oder neuer Wörter, was zu einem vielfältigeren und kreativeren Text führt. Dahingegen resultiert ein niedrigerer Wert in häufigerer Verwendung gängiger Wörter, was den Text leichter verständlich machen kann.

Typischerweise werden Werte um 0,1 genutzt, um die Anzahl von Wiederholungen leicht zu reduzieren. Hohe Werte sorgen dafür dass sich das Modell gar nicht mehr wiederholt. Das kann die Qualität des Textes stark beeinträchtigen.

Max Tokens - Wie stelle ich die Länge der Antworten in ChatGPT ein?

“Max Tokens” legt fest, wie viele Token das Modell maximal in einer Antwort generieren darf. Ein Token kann ein Wort oder ein Teil eines Wortes sein und entspricht grob einer Silbe. Dieser Parameter dient dazu, die Länge des generierten Textes zu kontrollieren.

Verwendung

Wenn “Max Tokens” zu niedrig eingestellt ist, kann dies zu abgeschnittenen und unverständlichen Antworten führen. Ist es zu hoch eingestellt, können unnötig lange und ausschweifende Antworten entstehen.Über diesen Parameter lassen sich auch Kosten reduzieren, da bei Nutzung der OpenAI-API nach generierten Tokens abgerechnet wird. Durch die richtige Einstellung von “Max Tokens” können Entwickler und Nutzer die Länge und Qualität der generierten Antworten optimieren und gleichzeitig die Kosten kontrollieren.

Optimale Einstellung der ChatGPT Parameter

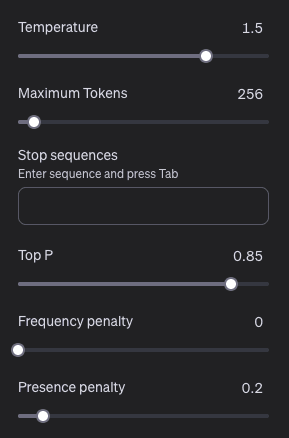

Optimale Einstellung der ChatGPT Parameter für kreative Texte

Bei der Erstellung von kreativen Texten, z.B. zu Brainstorming Zwecken sollte die Temperatur & Frequency Penalty erhöht und Top-P abgesenkt werden. Der Maximum Tokens Parameter sollte nach Bedarf nachjustiert werden, um unnötige Kosten zu vermeiden.

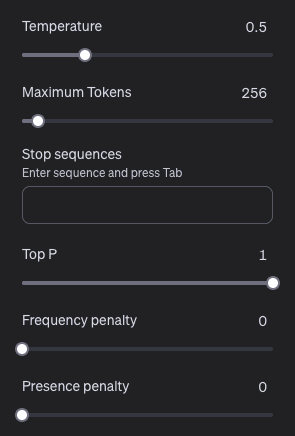

Optimale Einstellungen der ChatGPT Parameter für neutrale Inhalte

Hier bietet es sich an die Parameter eher auf den Standardeinstellunge zu belassen und lediglich den Temperaturwert nach unten zu korrigieren.

Fazit

Es grundsätzlich sinnvoll die oben beschriebenen Parameter im Zuge der Aufgabe selbst zu justieren bis man mit den Ausgaben vollkommen zufrieden ist.